Google Cloud 宣布 Vertex AI 平台重大升級,助力企業加速 AI 服務部署

章節連結

- Gemini 1.5 Flash:高效能的輕量級 AI 模型

- Gemini 1.5 Pro:領先業界的 200 萬詞元脈絡能力

- Imagen 3:更快速生成圖像,精確解析指令

- Vertex AI 引進第三方和開放模型 提供更多模型選擇

- Gemini 1.5 Pro 和 Flash 的脈絡快取功能(Context Caching)有效降低成本效益

- Gemini 模型預先配置處理量(provisioned throughput)提前預測效能

- 傳遞「企業真理」(enterprise truth):以 Google 搜尋和第三方資料作為連結(grounding) 基礎

- 採用高度傳真(high-fidelity)模式連結資料 以提供貼近事實的回應

Google Cloud 宣布,旗下專為企業設計的 AI 平台 Vertex AI 進行了重要的模型和功能升級。此次更新引入數十項新功能,致力於優化平台的調整、強化、自訂和擴展能力,同時提升可靠性和安全性,幫助企業更迅速地推出高效的 AI 虛擬服務專員。

Gemini 1.5 Flash:高效能的輕量級 AI 模型

Google Cloud 於五月推出了 Gemini 1.5 Flash 的公開預覽版,現已全面開放使用。這款模型以其低延遲和高性價比脫穎而出,擁有長達 100 萬個詞元(token)的脈絡長度(context window),為大規模應用場景提供理想解決方案。無論是零售客服、文書處理,還是整合整個倉儲(repositories)的研究虛擬專員,Gemini 1.5 Flash 都表現卓越。

該模型因其強大的性能和成本效益,迅速成為企業用戶的首選。與 GPT-3.5 Turbo 等競爭模型相比,Gemini 1.5 Flash 展現了以下幾個關鍵優勢:

- 擁有 100 萬個詞元的脈絡長度,遠超 GPT-3.5 Turbo 約 60 倍。

- 在處理 1 萬個字元時,速度平均提升 40% 。

- 啟用脈絡快取(context caching)功能處理超過 32,000 個字元的輸入時,輸入成本可降低至 GPT-3.5 Turbo 的四分之一。

企業及開發者可以立即在 Vertex AI 上開始使用 Gemini 1.5 Flash 。

Gemini 1.5 Pro:領先業界的 200 萬詞元脈絡能力

Gemini 1.5 Pro 現已推出,具備高達 200 萬個詞元的脈絡處理能力,適合獨特的多模態應用案例。這些能力特別適合處理諸如影片分析、大型程式碼庫中的錯誤檢測,以及深度研究資料挖掘等需求。

例如,處理一部 6 分鐘的影片需要超過 10 萬個詞元,而處理大型程式庫則可能需要超過 100 萬個詞元。 Gemini 1.5 Pro 能夠在這些情境下發揮出色的性能,為企業和開發者提供前所未有的解決方案。現在就點擊此處,開始使用具有 200 萬個詞元處理能力的 Gemini 1.5 Pro 。

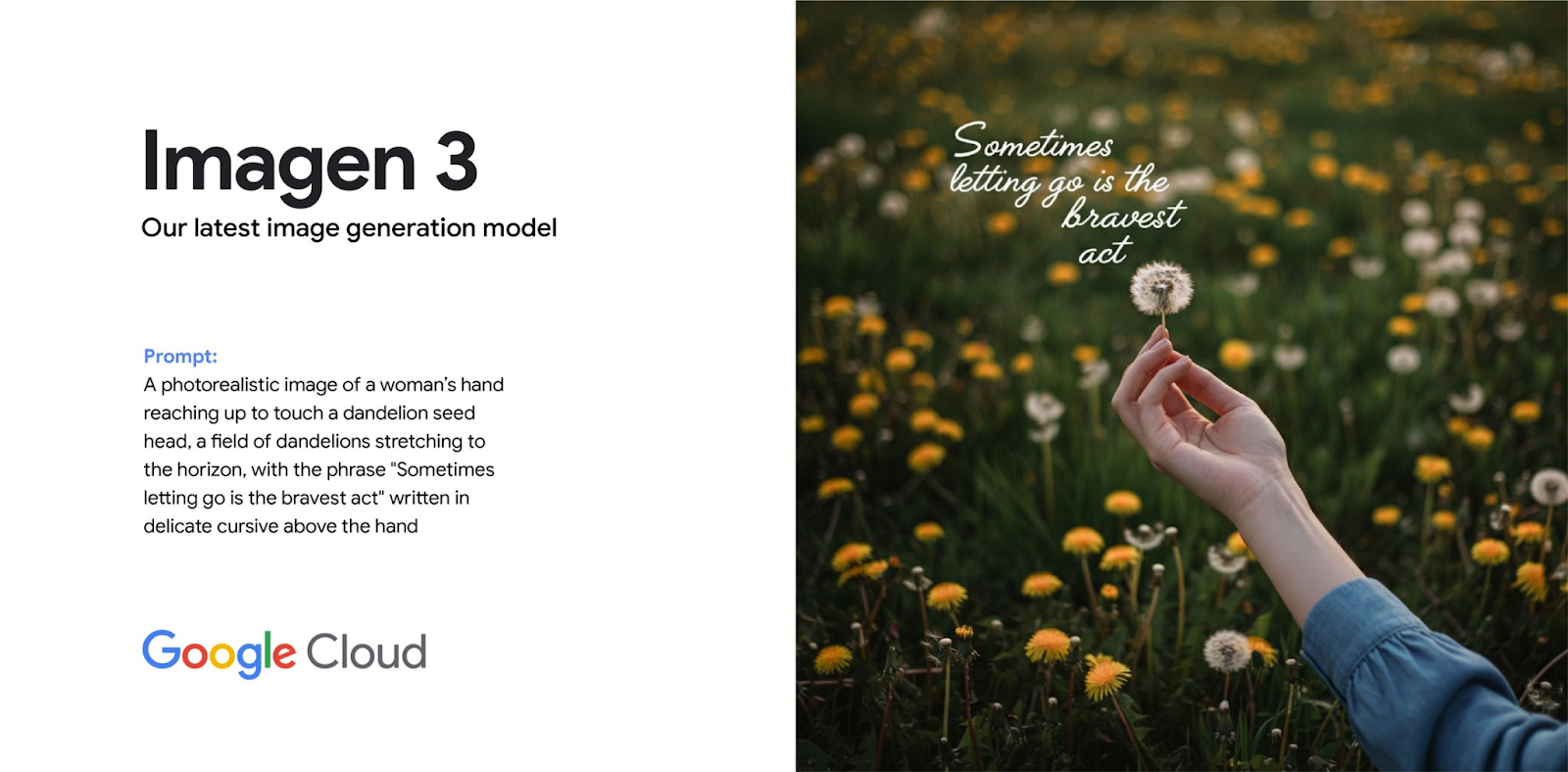

Imagen 3:更快速生成圖像,精確解析指令

Google 最先進的圖像生成基礎模型 Imagen 3 提供出色的影像品質,比其前代產品 Imagen 2 更具優化功能。新模型加快了圖像生成速度超過 40%,並強化了提示理解和指令遵循能力,使得生成的圖像更加真實和精確。

Imagen 3 預覽版已經開放給有申請 Vertex AI 早期實驗階段的客戶試用,支援多語言、多種畫面比例,並內建先進的安全功能,如 Google DeepMind 的 SynthID 數位浮水印。企業和開發者可點擊此處了解更多,申請體驗 Imagen 3 在 Vertex AI 上的強大功能。

Vertex AI 引進第三方和開放模型 提供更多模型選擇

Google Cloud 在 Vertex AI 平台上提供多樣化的模型選擇,以增強客戶的創新能力。最近,Google Cloud 新增了 Anthropic 推出的 Claude 3.5 Sonnet 模型。客戶可以立即在 Google Cloud 上使用 Claude 3.5 Sonnet 模型進行實驗或部署到生產環境中。預計今年夏末,Google Cloud 將進一步擴展與 Mistral 的合作,將 Mistral Small 、 Mistral Large 和 Mistral Codestral 加入到 Vertex AI Model Garden 中。

Google 早前推出了 Gemma 系列,這是一系列基於 Gemini 模型技術的先進輕量級開放模型。現在,Google 正式推出全球研究和開發人員可使用的 Gemma 2 。 Gemma 2 提供了 90 億和 270 億兩種參數規格的選擇,比第一代更強大、更高效,同時大幅增強了內建安全性系統。客戶即將於下個月在 Vertex AI 平台上體驗 Gemma 2 的強大功能。

Google Cloud 現在為 Gemini 1.5 Pro 和 Flash 模型推出了脈絡快取功能的公開預覽版,旨在幫助客戶有效利用這些模型的龐大脈絡長度。一般來說處理較長脈絡的應用程式可能需要高成本且速度緩慢,這使得在生產環境中難以部署。 Vertex AI 的脈絡快取技術利用常見脈絡的快取數據,能夠顯著降低客戶高達 75% 的成本。 Google 目前是唯一提供脈絡快取 API 的供應商。

Gemini 1.5 Pro 和 Flash 的脈絡快取功能(Context Caching)有效降低成本效益

為了讓客戶更有效地運用 Gemini 強大的脈絡長度,Google Cloud 推出了 Gemini 1.5 Pro 和 Flash 模型的全新功能:脈絡快取。隨著脈絡長度增加,處理更長的應用程式可能會帶來高昂的成本和緩慢的速度,這使得在生產環境中部署變得困難。 Vertex AI 的脈絡快取技術利用常見的脈絡快取數據,可以大幅降低客戶達 75% 的成本。現在,Google 是唯一提供脈絡快取 API 的供應商,為客戶帶來了更靈活和成本效益的選擇。

Gemini 模型預先配置處理量(provisioned throughput)提前預測效能

從今天開始,為授權可用名單的客戶提供 Gemini 模型的預先配置處理量。這項服務能夠協助客戶以負責任的方式擴展他們對 Google 第一方模型(如 1.5 Flash)的使用,從而穩定容量和價格。 Vertex AI 的這項功能為客戶提供了生產工作負載的可預測性和可靠性,讓他們能夠放心地擴展生成式 AI 的應用。

傳遞「企業真理」(enterprise truth):以 Google 搜尋和第三方資料作為連結(grounding) 基礎

讓企業的 AI 能夠完備上路,不僅需要依賴優秀的模型,還需要建立在真實事實的基礎上,以最大程度降低 AI 誤判的風險。企業需要將模型輸出的結果建立在網路、第一方和第三方事實和資料的基礎上,同時還要滿足資料治理及主權等嚴格的企業就緒標準。

在 Google I/O 大會上,Google 宣布全面開放 Vertex AI 中的 Google 搜尋連結服務(Grounding with Google Search)。此外,Google Cloud 還宣布,從下個季度開始,Vertex AI 將推出一項新服務,讓客戶能夠整合專業的第三方資料,強化其 AI 虛擬服務專員。這將有助於提升企業應用中的資料可信度,同時開啟獨特的應用案例。

Google Cloud 正在與 Moody’s 、 MSCI 、 Thomson Reuters 和 Zoominfo 等主要供應商合作,將他們的資料導入此服務中。

「Google Cloud 的第三方資料連結服務將使 KPMG 和我們的客戶開創新的應用商機。將來自產業領導者的專業第三方資料流暢整合到我們的生成式 AI 產品中,我們能縮短洞察時間,做出更明智的決策,最終更可以運用擁有高信賴度的資料來源,為客戶提供更大的價值。」- KPMG 全球稅務與法律技術長 Brad Brown

採用高度傳真(high-fidelity)模式連結資料 以提供貼近事實的回應

現在就開始使用 Vertex AI

歡迎點選此處進一步瞭解 Vertex AI 能為你的組織提供哪些幫助,若要進一步瞭解 Google Cloud 客戶如何運用生成式 AI 進行創新,請參閱 101 個來自全球頂尖組織的生成式 AI 應用案例。